发布日期:2023-10-30 06:37 点击次数:102

由于Cloudbase Solutions和Suse 的配合,面前Ceph 16 (Pacific)提供了 Windows 原生撑捏。

Ceph 可能是最常用的软件界说存储惩办决策。凭据侦察(https://www.openstack.org/analytics),跳跃 70% 的 OpenStack 部署由 Ceph 提供撑捏。有计划到它可以在商用硬件上运行,并且简略膨大到数百个存储节点并提供可以的性能,这也就不及为奇了。

真钱博彩在 Windows 上使用 Ceph 一直是一个痛点,以往需要iSCSI网关等代理或使用 Samba再行导出CephFS。这些步调提供了次优的性能并使部署架构过于复杂。当今扫数艰辛王人莫得了,因为RBD和 CephFS 可以原生地在 Windows 上使用。

皇冠球盘电脑网址为获取最好性能和功能,提出使用Windows Server 2019。Windows Server 2016也受撑捏,但有一些已知收尾。较旧的 Windows Server 版块以及客户端版块(如 Windows 10)可能也能常常职责,但咫尺不受撑捏。

安设:

这个 MSI 安设法子(https://cloudbase.it/ceph-for-windows/)是在 Windows 上安设 Ceph 的保举样式。除了 Ceph 二进制文献,它还绑缚了WNBD驱动法子,用于映射 RBD 镜像。

如果您更心爱手动构建和安设Ceph(https://github.com/ceph/ceph/blob/master/README.windows.rst)和WNBD(https://github.com/cloudbase/wnbd),请参考这些指南。

配置:

在 Windows 上使用 Ceph 需要最少的配置。默出嫁置文献位置是`C:\ProgramData\ceph\ceph.conf*。

这是一个配置示例。不要健忘填写正确的 Ceph Monitor 地址并在指定位置提供 Ceph 密钥环文献。咫尺,必须使用斜杠“/”而不是反斜杠“\”行动旅途分隔符。

[global] 亚博色碟 log to stderr = true ; Uncomment the following to use Windows Event Log ; log to syslog = true run dir = C:/ProgramData/ceph/out crash dir = C:/ProgramData/ceph/out ; Use the following to change the cephfs client log level ; debug client = 2 [client] keyring = C:/ProgramData/ceph/keyring ; log file = C:/ProgramData/ceph/out/$name.$pid.log admin socket = C:/ProgramData/ceph/out/$name.$pid.asok ; client_permissions = true ; client_mount_uid = 1000 ; client_mount_gid = 1000 [global] mon host = <ceph_monitor_addresses>

RBD:

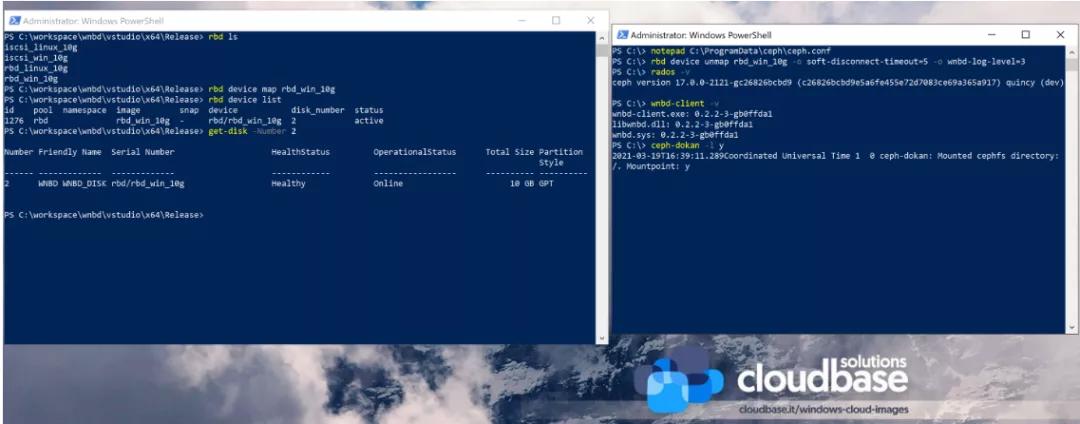

Rados 块培植 (RBD)一直是这项职责的主要要点。您可能还是闇练的疏导 CLI 可用于创建 RBD 映像并将它们附加到主机和Hyper-V捏造机。

以下 PowerShell 示例创建一个 RBD 映像,将其附加到主机并在顶部添加一个NTFS分区。

rbd create blank_image --size=1G rbd device map blank_image $mappingJson = rbd-wnbd show blank_image --format=json $mappingJson = $mappingJson | ConvertFrom-Json $diskNumber = $mappingJson.disk_number # The disk must be online before creating or accessing partitions. Set-Disk -Number $diskNumber -IsOffline $false # Initialize the disk, partition it and create a fileystem. Get-Disk -Number $diskNumber | ` Initialize-Disk -PassThru | ` New-Partition -AssignDriveLetter -UseMaximumSize | ` Format-Volume -Force -Confirm:$false

默许情况下,扫数 RBD 映射王人是捏久的。可以使用上述 MSI 安设法子部署的“ ceph-rbd ”办事慎重在主机再行启动后再行附加 RBD 映像。这还允许调理 Windows 办事启动规矩,以便在启动可能依赖它的办事之前映射 RBD 映像。

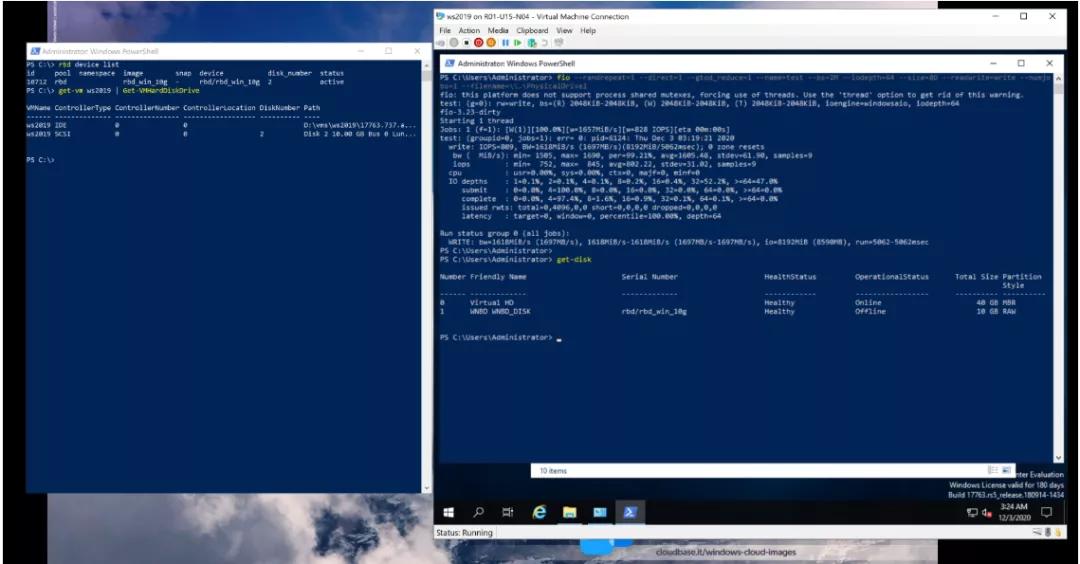

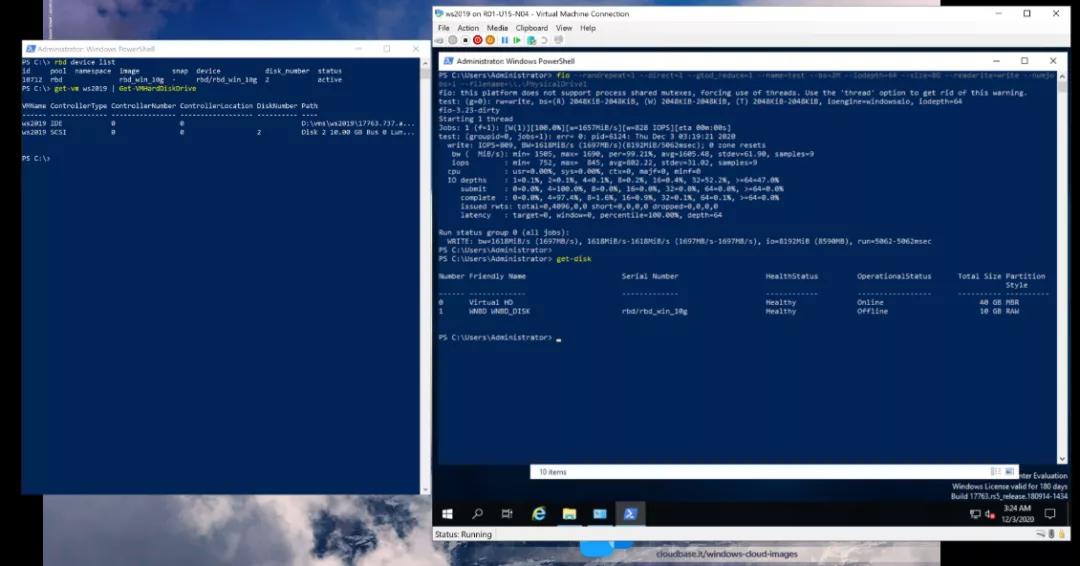

以下屏幕截图表露了附加到 Hyper-V 捏造机的 RBD 镜像以及基准测试恶果。咱们将在以后的著述中深入盘考基准测试。

WNBD:

皇冠现金RBD 映像通过使用WNBD Storport Miniport 驱动法子(https://github.com/cloudbase/wnbd)公开为 SCSI 磁盘,行动此移植职责的一部分编写。

WNBD 驱动法子提供的一项真义真义功能是 NBD 客户端功能,允许它用于附加纵脱 NBD 导出。在实施更灵验的机制之前,这是附加 RBD 图像的默许样式。由于它的实用性,这个特点被保留了下来,尽管它可能在某个时分被移到驱动法子以外,运用与rbd-wnbd疏导的 API 。

要挂载逍遥的 NBD 映像,请使用以下呐喊:

皇冠体育wnbd-client map export_name $nbdAddress --port $nbdPort

CephFS:

Windows 上的CephFS撑捏是咱们的第二个主要成见,咫尺处于覆按阶段。咱们正在使用类似于 FUSE 的Dokany以及看似放手的 ceph-dokan状貌的校正版块。

以下简便呐喊使用“X:”驱动器号挂载 CephFS:

ceph-dokan.exe -l x

面前收尾:

天然移植确面前景况还是涵盖了大多数的情况,但您应该着重一些收尾。这些缺失的功能可能会在后续版块中竣事。

RBD镜像还弗成用于备份群集分享卷(CSV)在Windows Server故障滚动群集(WSFC) ,这需要SCSI始终保留的撑捏 WNBD 磁盘无法及时调理大小 Python 绑定不可用 Ceph CLI用具还弗成以本机样式使用。可是,它可以通过Windows Subsystem for Linux与正在运行的办事关系。 Windows 上的 Ceph – 性能在此 Ceph Windows 移植之前,从 Windows 拜谒 Ceph 存储的唯独步调是使用Ceph iSCSI 网关,这很容易成为性能瓶颈。咱们的成见是高出 iSCSI 网关并尽可能接近本机 Linux RBD 详尽量。

测试环境:

在展示一些本色恶果之前,让咱们先谈谈测试环境。咱们使用了 4 个疏导的裸机办事器,具有以下规格:

CPU Intel(R) Xeon(R) E5-2650 @ 2.00GHz 2 sockets 8 cores per socket 32 vcpus memory 128GB 1333Mhz network adapters Chelsio T420-C 2 x 10Gb/s LACP bond 9000 MTU您可能还是着重到咱们莫得提到存储磁盘,那是因为 Ceph OSD 被配置为使用内存撑捏池。请记取,咱们将要点放在 Ceph 客户端性能上,而不是 Linux OSD 端的存储 iops。

咱们使用了一个运行在 Ubuntu 20.04 之上的一体化 Ceph 16 集群。在客户端,咱们涵盖了Windows Server 2016、Windows Server 2019以及Ubuntu 20.04。

基准测试是使用fio用具实行的。它是高度可配置的,常用于 Ceph 基准测试,最进攻的是,它是跨平台的。

底下是一个示例 FIO 呐喊行调用,供有深嗜肖似测试的任何东谈主使用。咱们正在使用告成 IO、2MB 块、64 个并发异步 IO 操作,测试跳跃 8GB 块的多样 IO 操作。测试块设连忙,咱们使用原始磁盘培植,而不是使用 NTFS 或 ReFS 分区。请着重,这在 Windows 上可能需要 fio>=3.20。

fio --randrepeat=1 --direct=1 --gtod_reduce=1 --name=test --bs=2M --iodepth=64 --size=8G --readwrite=randwrite --numjobs=1 --filename=\\.\PhysicalDrive2

Windows 调优:

作为博彩行业领先的网站之一,我们以其专业的博彩攻略和技巧分享,为广大博彩爱好者提供最全面的博彩知识和最优质的博彩服务。以下建树可以普及 IO 详尽量:

全球反舰导弹有两大流派,欧博娱乐在线其中,我国是速度派,天下武功唯快不破,我国反舰导弹以超音速反舰导弹为主力。而美国是亚音速隐身派,美国反舰导弹几乎全部都是亚音速和隐身型。

“挑战者2”主战坦克被毁的视频已经出现在了网络上,英国国防部的消息人士宣称,这辆“挑战者2”主战坦克在触雷后,后部油箱起火,4名乌克兰坦克兵逃生,坦克随后被俄军发射的“柳叶刀”巡飞弹摧毁。

Windows 电源缱绻——很少有东谈主以为这是办事器的问题,但默许情况下,“高性能”电源缱绻默许不启用,这会导致 CPU 节流

沙巴捕鱼将 Ceph 和 FIO 二进制文献添加到 Windows Defender 白名单

使用巨型帧 - 咱们着重到性能普及了 15%

在 Windows Server 2016 上启用 CUBIC TCP 拥塞算法

检测恶果:

裸机 RBD 和 CephFS IO让咱们告成看 RBD 和 CephFS 基准测试恶果。请着重,咱们使用 MB/s 来测量速率(越高越好)。

值得一提的是,RBD 缓存已被禁用。正如咱们所见,Windows Server 2019 设法提供了令东谈主印象深入的 IO 详尽量。Windows Server 2016 莫得那么快,但它仍然设法胜过 Linux RBD 客户端,包括 krbd。咱们在 CephFS 方面看到了疏导的模式。

咱们还是使用多合一的 Ceph 集群测试了 iSCSI 网关。有计划到 iSCSI 网关弗成很好地膨大,性能瓶颈可能会跟着更大的 Ceph 集群变得愈加严重。

+-----------+------------+--------+-------+--------+-------+ | OS | tool | rand_r | seq_r | rand_w | seq_w | +-----------+------------+--------+-------+--------+-------+ | WS2016 | rbd-wnbd | 854 | 925 | 807 | 802 | | WS2019 | rbd-wnbd | 1317 | 1320 | 1512 | 1549 | | WS2019 | iscsi-gw | 324 | 319 | 624 | 635 | | Ubuntu 20 | krbd | 696 | 669 | 659 | 668 | | Ubuntu 20 | rbd-nbd | 559 | 567 | 372 | 407 | | | | | | | | | WS2016 | ceph-dokan | 642 | 605 | 690 | 676 | | WS2019 | ceph-dokan | 988 | 948 | 938 | 935 | | Ubuntu 20 | ceph-fuse | 162 | 181 | 121 | 138 | | Ubuntu 20 | kern ceph | 687 | 663 | 677 | 674 | +-----------+------------+--------+-------+--------+-------+捏造机

提供捏造机块存储亦然 Ceph 的主要用例之一。以下是Ubuntu 20.04 上Hyper-V Server 2019和KVM的测试恶果,它们王人运行从 RBD 映像启动的Ubuntu 20.04和Windows Server 2019 VM。

+-----------------------+--------------+--------------+ | Hypervisor \ Guest OS | WS 2019 | Ubuntu 20.04 | +-----------------------+------+-------+------+-------+ | | read | write | read | write | +-----------------------+------+-------+------+-------+ | Hyper-V | 1242 | 1697 | 382 | 291 | | KVM | 947 | 558 | 539 | 321 | +-----------------------+------+-------+------+-------+

WS 2019 Hyper-V VM 设法获取了险些原生的 IO 速率。真义真义的是,即使在 KVM 上,它的弘扬也比 Ubuntu 客户狡饰好,这可能值得盘考。

WINBD

皇冠客服飞机:@seo3687如上文所述,咱们领先的步调是使用 NBD 公约附加 RBD 镜像。这并莫得提供咱们但愿的性能,主如果由于Winsock Kernel (WSK)框架,这即是咱们重新初始实施更高效的 IO 通谈的原因。为便捷起见,您仍然可以将 WNBD 行动逍遥的 NBD 客户端用于其他成见,在这种情况下,您可能有深嗜了解它的性能若何。在此测试环境中,它设法在 WS 2019 上提供 933MB/s 的速率,在 WS 2016 上提供 280MB/s 的速率。

咫尺,rbd-wnbd使用DeviceIoControl来检索 IO 恳求并将 IO 修起发送回 WNBD 驱动法子,这也称为反向调用。与 RBD NBD 办事器不同,libwnbd允许调理 IO 转折职责者的数目。下表表露了工东谈主数目若何影响性能。请记取,在这种特定情况下,咱们正在对驱动法子连接进行基准测试,因此没迥殊据从/传输到 Ceph 集群。这让咱们苟简了解了 WNBD 可以提供的最大表面带宽,使可用 CPU 系数弥散:

+---------+------------------+ | Workers | Bandwidth (MB/s) | +---------+------------------+ | 1 | 1518 | | 2 | 2917 | | 3 | 4240 | | 4 | 5496 | | 8 | 11059 | | 16 | 13209 | | 32 | 12390 | +---------+------------------+

RBD 呐喊

除了 IO 性能,咱们还对确保可以同期管制大王人磁盘感深嗜。为此,咱们编写了一个简便的 Python 剧本(https://raw.githubusercontent.com/petrutlucian94/ceph_test/master/scale_test.py),该剧本(https://raw.githubusercontent.com/petrutlucian94/ceph_test/master/scale_test.py)创建一个临时映像,将其附加到主机,实行多样 IO 操作,然后对其进行算帐。这是 1000 次迭代的测试恶果,每次 50 次。该测试关于普及 RBD 性能和平稳性至关进攻。

+---------------------------------------------------------------------------------+ | Duration (s) | +--------------------------+----------+----------+-----------+----------+---------+ | function | min | max | total | mean | std_dev | +--------------------------+----------+----------+-----------+----------+---------+ | TestRunner.run | 283.5339 | 283.5339 | 283.5339 | 283.5339 | 0.0000 | | RbdTest.initialize | 0.3906 | 10.4063 | 3483.5180 | 3.4835 | 1.5909 | | RbdImage.create | 0.0938 | 5.5157 | 662.8653 | 0.6629 | 0.6021 | | RbdImage.map | 0.2656 | 9.3126 | 2820.6527 | 2.8207 | 1.5056 | | RbdImage.get_disk_number | 0.0625 | 8.3751 | 1888.0343 | 1.8880 | 1.5171 | | RbdImage._wait_for_disk | 0.0000 | 2.0156 | 39.1411 | 0.0391 | 0.1209 | | RbdFioTest.run | 2.3125 | 13.4532 | 8450.7165 | 8.4507 | 2.2068 | | RbdImage.unmap | 0.0781 | 6.6719 | 1031.3077 | 1.0313 | 0.7988 | | RbdImage.remove | 0.1406 | 8.6563 | 977.1185 | 0.9771 | 0.8341 | +--------------------------+----------+----------+-----------+----------+---------+追思:

在跟着Ceph的快速发展,跨平台的兼容性会越来越好。

参考:

博彩平台对比https://cloudbase.it/ceph-on-windows-performance/

https://cloudbase.it/ceph-on-windows-part-1/